نحوه عملکرد یادگیری تقویتی

در این مطلب درباره نحوه عملکرد سیستمهای یادگیری تقویتی صحبت خواهیم کرد. و مسئله را با ذکر چند مثال شرح و بسط خواهیم داد.

یادگیری تقویتی چگونه کار می کند؟

بیایید چند مثال ساده را مشاهده کنیم که به شما کمک می کند مکانیسم یادگیری تقویتی را بهتر درک کنید.

به عنوان مثال فرض کنید میخواهیم به گربه ترفندهایی جدیدی بیاموزیم.در ادامه نشا میدهیم این کار را چگونه میتوان با کمک یادگیری تقویتی انجام داد.

از آنجا که گربه انگلیسی یا هیچ زبان انسانی دیگری را نمی فهمد، ما نمی توانیم مستقیماً به او بگوییم چه کار کند. در عوض، ما استراتژی متفاوتی را دنبال می کنیم.پس بدین صورت عمل میکنیم،ما از موقعیتی تقلید می کنیم و گربه سعی می کند به روش های مختلف پاسخ دهد. اگر پاسخ گربه به روش دلخواه باشد ، به او ماهی می دهیم.

از این پس، هر زمان که گربه در معرض شرایط مشابهی قرار می گیرد، گربه نیز در انتظار دریافت پاداش بیشتر (غذا) با اشتیاق بیشتری اقدام مشابهی را انجام می دهد.با این کار گربه متوجه میشود که برای گرفتن پاداش باید چه عملی را انجام دهد. و همچنین گربه میآموزد در هنگام تجربیات منفی نیز باید چه عملی را انجام دهد.

اصطلاحات یادگیری تقویتی:

در مورد یادگیری تقویتی یک سری اصطلاحات و مفاهیم مهم وجود دارد که ابتدا به توضیح آنها میپردازیم:

عامل: یک موجود فرض شده است که برای به دست آوردن پاداش در محیطی اقداماتی را انجام می دهد.

محیط: سناریویی که عامل با آن روبرو میشود.

پاداش: عکس العملی نسبت به عامل هنگامی که او عمل یا وظیفه خاصی را انجام می دهد.

حالت: حالت به وضعیت فعلی بازگردانده شده توسط محیط اشاره دارد.

Policy: این یک استراتژی است که توسط عامل برای تصمیم گیری در مورد اقدام بعدی بر اساس وضعیت فعلی اعمال می شود.

تایع ارزش: مقدار کل پاداش را مشخص میکند.

مدل محیط: این رفتار محیط را تقلید می کند.به شما کمک می کند تا نتیجه گیری کنید و همچنین نحوه رفتار محیط را تعیین کنید.

روشهای مبتنی بر مدل: این روشی برای حل مشکلات یادگیری تقویتی است که از روشهای مبتنی بر مدل استفاده می کند.

مقدار Q یا مقدار عمل (Q): مقدار Q کاملا شبیه به Value (ارزش) است. تنها تفاوت بین این دو این است که یک پارامتر اضافی را به عنوان یک عمل فعلی می گیرد.

حال به مثال قبل برمیگردیم:

در مثال ذکر شده،گربه عامل و خانه شما محیط است. و یک مثال از حالت میتواند “گربه نشسته باشد.” در این حالت شما از کلمه خاصی برای راه رفتن استفاده میکنید.

حال،عامل ما با انجام عملی از حالتی به حالت دیگر میرود. به عنوان مثال، گربه شما از حالت نشسته به راه رفتن می رود.

واکنش یک عامل یک عمل است و Policy روشی است برای انتخاب یک عمل با توجه به وضعیتی که در انتظار نتایج بهتر است. پس از انتقال، آنها ممکن است در عوض پاداش یا مجازات دریافت کنند.

الگوریتم های یادگیری تقویتی:

سه الگوریتم برای این مسئله وجود دارد.

مبتنی بر ارزش:در روش یادگیری تقویت مبتنی بر ارزش، باید سعی کنید تابع مقدارها V را به حداکثر برسانید. در این روش، عامل انتظار بازگشت بلند مدت حالات فعلی تحت سیاست π را دارد.

مبتنی بر سیاست: در این روش متد RL ، شما سعی میکنید چنین سیاستی را ارائه دهید تا اقدامی که در هر حالت انجام می شود به شما کمک کند حداکثر پاداش را در آینده بدست آورید.

دو نوع از متدهای سیاست وجود دارد:

قطعی: برای هر محیط، همان عمل توسط سیاست π انجام می شود.

تصادفی: هر عملی دارای احتمال خاصی است که توسط معادله زیر تعیین می شود. سیاست تصادفی:

[n{a\s) = P\A, = a\S, =S

مبتنی بر مدل:در این روش یادگیری تقویتی، شما باید یک مدل مجازی برای هر محیط ایجاد کنید. عامل یاد می گیرد که در آن محیط خاص عمل کند.

انواع یادگیری تقویتی:

دو نوع روش وجود دارد. در ادامه به شرح آنها میپردازیم.

مثبت:به عنوان یک رویداد تعریف می شود که به دلیل رفتار خاص رخ می دهد. قدرت و دفعات رفتار را افزایش می دهد و بر عملکرد انجام شده توسط عامل تأثیر مثبت می گذارد.

این نوع تقویت به شما کمک می کند تا عملکرد را به حداکثر برسانید و تغییرات را برای مدت طولانی تری حفظ کنید. با این حال، تقویت بیش از حد ممکن است منجر به بهینه سازی بیش از حد حالت شود، که می تواند نتایج را تحت تأثیر قرار دهد.

منفی:تقویت منفی عبارت است از تقویت رفتاری که به دلیل شرایط منفی رخ می دهد که باید متوقف یا اجتناب شود. به شما کمک می کند تا حداقل وضعیت را تعیین کنید. با این حال ، اشکال این روش این است که به اندازه کافی برای برآوردن حداقل رفتار ارائه می دهد.

الگوهای یادگیری تقویتی:

در یادگیری تقویتی دو مدل یادگیری مهم وجود دارد:

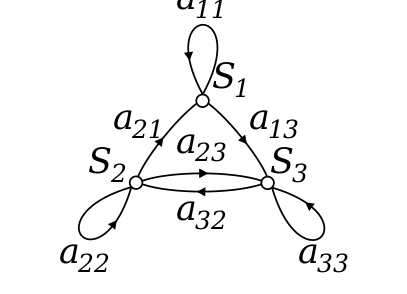

- فرایند تصمیم گیری مارکوف

- Q learning

مراحل روش مارکوف:

برای به دست آوردن راه حل از پارامترهای زیر استفاده می شود:

- مجموعه اعمال

- مجموعه محیطها

- پاداش

- سیاست

- ارزش

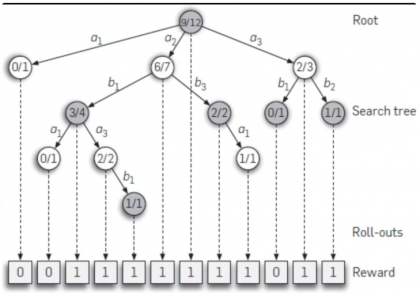

رویکرد ریاضی برای ترسیم راه حل در یادگیری تقویتی به عنوان فرایند تصمیم گیری مارکوف یا (MDP) را در ادامه میبینید.

Q-learning:یک روش مبتنی بر ارزش برای ارائه اطلاعات برای اطلاع از اقداماتی است که یک عامل باید انجام دهد.

در ادامه برای درک بهتر به ارائه یک مثال میپردازیم. فرض کنید داشته باشیم:

- در یک ساختمان پنج اتاق وجود دارد که توسط درها به هم متصل می شوند.

- شماره هر اتاق 0 تا 4 است

- بیرون ساختمان می تواند یک محوطه بزرگ خارجی باشد (5)

- شماره درهای1 تا 4 داخل ساختمان هستند.

در مرحله بعد، باید مقدار پاداش را به هر درب را محاسبه کنید:

- درهایی که مستقیماً به هدف منتهی می شوند 100 پاداش دارند

- درهایی که مستقیماً به اتاق مورد نظر متصل نیست پاداش صفر می دهد

- درها دو طرفه هستند و برای هر اتاق دو پیکان تعیین شده است

- هر پیکان در تصویر بالا دارای یک مقدار پاداش است

در تصویر زیر، می توانید مشاهده کنید که اتاق نشان دهنده یک حالت است

حرکت عامل از یک اتاق به اتاق دیگر نشان دهنده یک عمل است

در تصویر زیر، یک حالت به عنوان یک گره توصیف شده است، در حالی که فلش ها عمل را نشان می دهند.

به عنوان مثال انتقال عامل از اتاق 2 به 5 را در نظر بگیرید.

- حالت اولیه،اتاق 2 است.

- از حالت 2 تنها به حالت 3 راه دارد.

- از حالت 3 به حالت های (2و1و4) میتوان رفت.

- از حالت 4 به حالتهای(0و5و3) میتوان رفت.

- از حالت 1 به حالتهای (5و3)

- از حالت 0 به حالت 4 میتوان رفت.

مقایسه یادگیری تقوتی در مقابل یادگیری نظارت شده:

| پارامترها | یادگیری تقویتی | یادگیری نظارت شده |

|---|---|---|

| سبک تصمیم گیری | یادگیری تقویتی به شما کمک می کند تا تصمیمات خود را به صورت دنباله متوالی بگیرید. | در این روش، تصمیمی در مورد ورودی داده شده در ابتدا گرفته می شود. |

| عمل میکند | روی تعامل با محیط کار می کند. | روی نمونه هایی از داده های نمونه داده شده کار می کند. |

| وابسته به تصمیمگیری | در روش RL تصمیم گیری برای یادگیری وابسته است. بنابراین، باید به همه تصمیمات وابسته برچسب بزنید. | یادگیری تصمیمات مستقل از یکدیگر، بنابراین برای هر تصمیم برچسب هایی داده می شود. |

| بهترین موقعیت | در هوش مصنوعی، جایی که تعاملات انسانی شایع است، پشتیبانی و کار می کند. | بیشتر با یک سیستم نرم افزاری تعاملی یا برنامه های کاربردی کار می کند. |

| مثال | بازی شطرنج | شناسایی اشیا |

کاربردهای یادگیری تقویتی:

- رباتیک برای اتوماسیون صنعتی

- برنامه ریزی استراتژی کسب و کار

- یادگیری ماشین و پردازش داده ها

- این به شما کمک می کند تا سیستم های آموزشی ایجاد کنید که دستورالعمل ها و مواد سفارشی را با توجه به نیاز دانش آموزان ارائه دهد.

- کنترل هواپیما و کنترل حرکت روبات

به چه دلیل از یادگیری تقویتی استفاده میکنیم؟

در اینجا دلایل اصلی استفاده از یادگیری تقویتی آورده شده است:

- این به شما کمک می کند تا دریابید که کدام موقعیت نیاز به عمل دارد.

- به شما کمک می کند تا دریابید کدام عمل بالاترین پاداش را در مدت زمان طولانی تر به ارمغان می آورد.

- یادگیری تقویتی همچنین به عامل با عملکرد پاداش یاد می دهد.

- همچنین به آن اجازه می دهد تا بهترین روش برای به دست آوردن پاداش های بزرگ را پیدا کند.

چه زمانی از یادگیری تقویتی استفاده نکنید؟

در موارد زیر شما نمی توانید از مدل یادگیری تقویتی استفاده کنید. در اینجا شرایطی وجود دارد که نباید از مدل یادگیری تقویتی استفاده کنید.

- وقتی اطلاعات کافی برای حل مسئله با یک روش یادگیری تحت نظارت دارید.

- باید به خاطر داشته باشید که یادگیری تقویتی محاسباتی سنگین و وقت گیر است. به ویژه هنگامی که فضای عمل بزرگ است.

چالشهای یادگیری تقویتی:

در اینجا مهمترین چالش هایی که هنگام استفاده از یادگیری تقویتی با آنها روبرو خواهید شد آمده است:

- طراحی ویژگی/پاداش که باید بسیار دخیل باشد.

- پارامترها ممکن است بر سرعت یادگیری تأثیر بگذارند.

- محیط های واقع بینانه می توانند از قابلیت مشاهده جزئی برخوردار باشند.

- تقویت بیش از حد ممکن است منجر به بارگذاری بیش از حد حالات شود که می تواند نتایج را کاهش دهد.

- محیطهای واقع بینانه می توانند غیر تغییر باشند.

دیدگاهتان را بنویسید